SHARE 0

SHARE 0

robots.txtとは?意味から設定方法まで詳しく解説

SEO |

こんにちは。SEOコンサルティングサービス「AIアナリストSEO」ライターチームです。

この記事では、robots.txtの意味やそのファイルの設置方法について詳しくご説明します。

robots.txtを活用することで、クロールされるコンテンツを制御して、有利なコンテンツをクロールさせることが可能になります。robots.txtを活用するとクロールを最適化することができ、SEOに良い効果をもたらします。結果として、流入数やCV数の向上に繋がるため、是非ご一読ください。

目次

SEO対策にお困りではありませんか?

株式会社WACULは、40,000サイトのデータと実績で貴社に最適なSEO対策をご提案する会社です。

robots.txtとは

robots.txtとは、収集されたくないコンテンツをクロールされないように制御するファイルです。

これにより検索エンジンのクローラー(=ロボット)に自サイトにとって重要なコンテンツを中心にクロールさせることができます。

(補足)

クローラーとは、ロボット型の検索エンジンがWeb上のファイルを収集するためのプログラムのことです。これによって集められたデータがインデックス化されて、巨大な検索デーベースが作成されます。

robots.txtのSEO効果

クロール不要なコンテンツをrobots.txtで制御することで、クロールの最適化が見込めます。クロールの最適化とは、サイト内の重要なページにたくさんクロールさせることです。サイト内の重要コンテンツはユーザにとっても価値のあるコンテンツである可能性が高く、短期間でSEO改善が見込めるようになります。

robots.txtの設定方法

robots.txtの書き方から確認方法、ファイルの設置方法をご説明します。

1.robots.txtファイルの書き方

robots.txtはFTPソフトを使って、テキストファイルで記述します。記述する内容は、

の3つの要素のみです。また、ファイル名は必ず「robots.txt」にします。これから各要素の意味や書き方についてご説明します。

User-Agentは、どのクローラーの動きを制御するかを指定します。たとえば、Googlebotと指定した場合、GoogleのWebクロールを制御することになります。しかし、基本的には「*」(すべてのクローラー、の意味)で指定して問題はありません。

Disallowは、クローラーのアクセスを制御するファイルを指定するものです。Disallowで指定されたファイルやディレクトリはクロールがブロックされます。Disallowで指定がない場合にはクロールが許可されることになるため、

Disallow:

といったように空白になっていれば、すべてのファイルやディレクトリがクロールの対象となります。

Disallow:/example/

と記載した場合には、このディレクトリ配下がブロックされます。

次にSitemapは、sitemap.xmlの場所をクローラーに伝えるものです。これを記述しておくとSitemapを積極的に読んでもらえるので、是非記載しておきましょう。

以上を踏まえてrobots.txtのテキストファイルを作ると以下のようになります。

(例)

User-Agent:*

Disallow:/example/

Sitemap:http://aaaaaa.jp/sitemap

2.ファイルが正しくかけているか確認する方法

サーバーに設置する前に、ファイルが正しくかかっているのか確認をしましょう。確認するのに、Googleサーチコンソールのrobots.txtテスターを使います。

「クロール>robots.txtテスター」をクリックし、1.で作成したテキストを貼り付け、「テスト」をクリックします。ここでファイルがしっかりブロックされたか確認ができます。

3.ファイルの設置方法

robot.txtファイルは、ドメインのルートディレクトリに設置します。これはrobot.txtという名前のテキストファイルを作成するだけです。ただし、サブディレクトリ型のサイトではこれは使えません。

○:http://aaaaaa.jp/robots.txt

×:http://aaaaaa.jp/bbb/robots.txt

そのためサブディレクトリ型のサイトに関してはrobots metaタグを使用する必要があります。

また、ファイルを設置してから反映されるまではタイムラグがありますので、ご注意ください。

まとめ

robots.txtの意味や設置方法についてこれまでご説明しました。robots.txtを活用してSEO対策を強化していきましょう!自然検索からの流入数を増やしていきましょう!

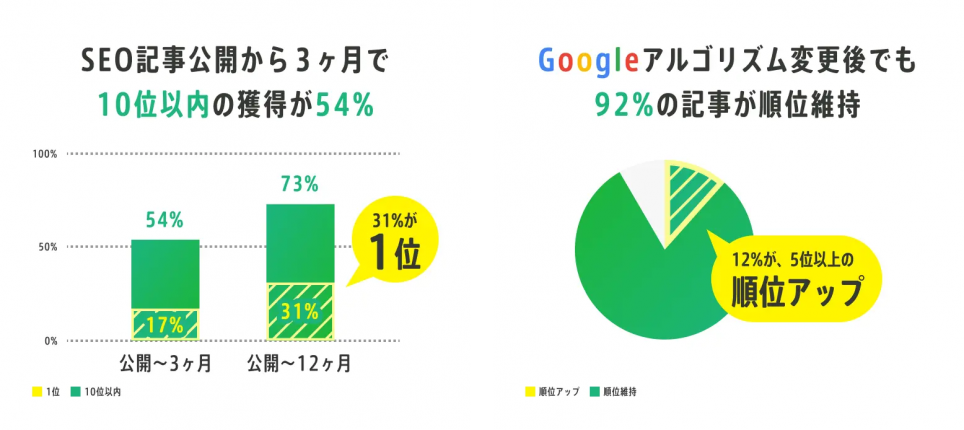

WACULが提供する「AIアナリストSEO」は、月額30万円で戦略から実行まで一貫サポートする「SEOコンサルティング」サービスです。本サービスは、貴社サイトデータだけでなく、競合サイトや弊社が保有するビックデータの分析に基づき、CV獲得に特化したSEO戦略を立案し、記事制作からCVR改善提案まで幅広くサポートいたします。

この記事を書いた人

株式会社WACUL

株式会社WACUL(ワカル)は、「Webサイト分析をシンプルに」というビジョンのもと、簡単にWebサイト改善の方針を手にすることができる世の中を実現します。

この記事を書いた人

株式会社WACUL